|

|

3.5. Количество информации, получаемой в процессе сообщения<<Назад | Содержание | Далее>>

До сих пор мы приводили формулы для расчета энтропии (неопределенности) H, указывая, что H в них можно заменять на I, потому что количество информации, получаемое при полном снятии неопределенности некоторой ситуации, количественно равно начальной энтропии этой ситуации. Но неопределенность может быть снята только частично, поэтому количество информации I, получаемой из некоторого сообщения, вычисляется как уменьшение энтропии, произошедшее в результате получения данного сообщения.

Для равновероятного случая, используя для расчета энтропии формулу Хартли, получим:

Второе равенство выводится на основании свойств логарифма. Таким образом, в равновероятном случае I зависит от того, во сколько раз изменилось количество рассматриваемых вариантов выбора (рассматриваемое разнообразие). Исходя из (5) можно вывести следующее: Если

Если

Если

Если количество рассматриваемых

альтернатив в результате получения сообщения уменьшилось вдвое,

т.е.

Рассмотрим в качестве примера опыт с колодой из 36 карт.

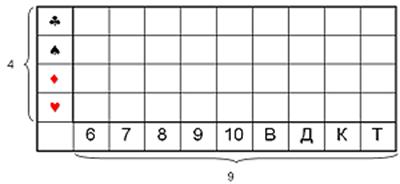

Рис. 12. Иллюстрация к опыту с колодой из 36-ти карт.

Пусть некто вынимает одну карту из колоды. Нас интересует, какую именно из 36 карт он вынул. Изначальная неопределенность, рассчитываемая по формуле (2), составляет H=log2(36)@5,17 бит. Вытянувший карту сообщает нам часть информации. Используя формулу (5), определим, какое количество информации мы получаем из этих сообщений:

Вариант A. “Это карта красной масти”. I=log2(36/18)=log2(2)=1 бит (красных карт в колоде половина, неопределенность уменьшилась в 2 раза).

Вариант B. “Это карта пиковой масти”. I=log2(36/9)=log2(4)=2 бита (пиковые карты составляют четверть колоды, неопределенность уменьшилась в 4 раза).

Вариант С. “Это одна из старших карт: валет, дама, король или туз”. I=log2(36)–log2(16)=5,17-4=1,17 бита (неопределенность уменьшилась больше чем в два раза, поэтому полученное количество информации больше одного бита).

Вариант D. “Это одна карта из колоды". I=log2(36/36)=log2(1)=0 бит (неопределенность не уменьшилась - сообщение не информативно).

Вариант D. “Это дама пик". I=log2(36/1)=log2(36)=5,17 бит (неопределенность полностью снята).

<<Назад | Содержание | Далее>> |

При копировании материалов обратная ссылка обязательна

Информатика в школе

2005-2017